Sztuczna inteligencja staje się zagrożeniem. Pilny komunikat prezesa UODO

Sztuczna inteligencja coraz śmielej wkracza w codzienne życie – od rozrywki po biznes, od edukacji po politykę. Dynamiczny rozwój tej technologii rodzi jednak pytania, na które wciąż brakuje jednoznacznych odpowiedzi. Czy państwo ma narzędzia, by chronić obywateli w świecie, w którym granica między prawdą a cyfrową fikcją staje się niemal niewidoczna? Coraz więcej sygnałów wskazuje, że system prawny może być o krok za rzeczywistością.

- Prawo sprzed epoki algorytmów

- Ukryte zagrożenia sztucznej inteligencji

- Co trzeba zmienić, by chronić obywateli

Prawo sprzed epoki algorytmów

Choć może się wydawać, że prawo nadąża za cyfrową rewolucją, rzeczywistość wygląda znacznie mniej optymistycznie. Obowiązujące regulacje dotyczące ochrony danych osobowych, wizerunku czy dóbr osobistych powstawały w czasach, gdy skala i możliwości technologiczne były nieporównywalnie mniejsze. Dziś te same przepisy coraz częściej okazują się niewystarczające wobec narzędzi opartych na sztucznej inteligencji.

Problemem nie jest wyłącznie brak nowych ustaw. Istniejące regulacje teoretycznie pozwalają reagować na naruszenia, jednak w praktyce system często zawodzi. Organy ścigania i instytucje publiczne nie zawsze potrafią prawidłowo zakwalifikować czyny popełniane przy użyciu algorytmów. W efekcie ofiary cyfrowych manipulacji słyszą, że „to tylko internet”, „to nie jest realna krzywda” albo że brakuje podstaw prawnych do działania.

Szczególnie dotkliwe są sytuacje, w których technologia wykorzystywana jest przeciwko osobom najbardziej bezbronnym. Przypadki wykorzystywania wizerunku dzieci czy młodzieży pokazują, że brak szybkiej i jednoznacznej reakcji państwa prowadzi do poczucia bezkarności sprawców. Dopiero interwencje instytucji wyspecjalizowanych w ochronie danych osobowych często uruchamiają realne działania prokuratury. To dowód na systemową lukę, która wymaga pilnego zamknięcia.

Ukryte zagrożenia sztucznej inteligencji

Największe emocje budzą dziś tzw. deepfake’i – realistyczne fałszerstwa obrazu i dźwięku. Jednak to tylko wierzchołek góry lodowej. Znacznie poważniejsze zagrożenia kryją się głębiej i są mniej widoczne dla przeciętnego użytkownika Internetu.

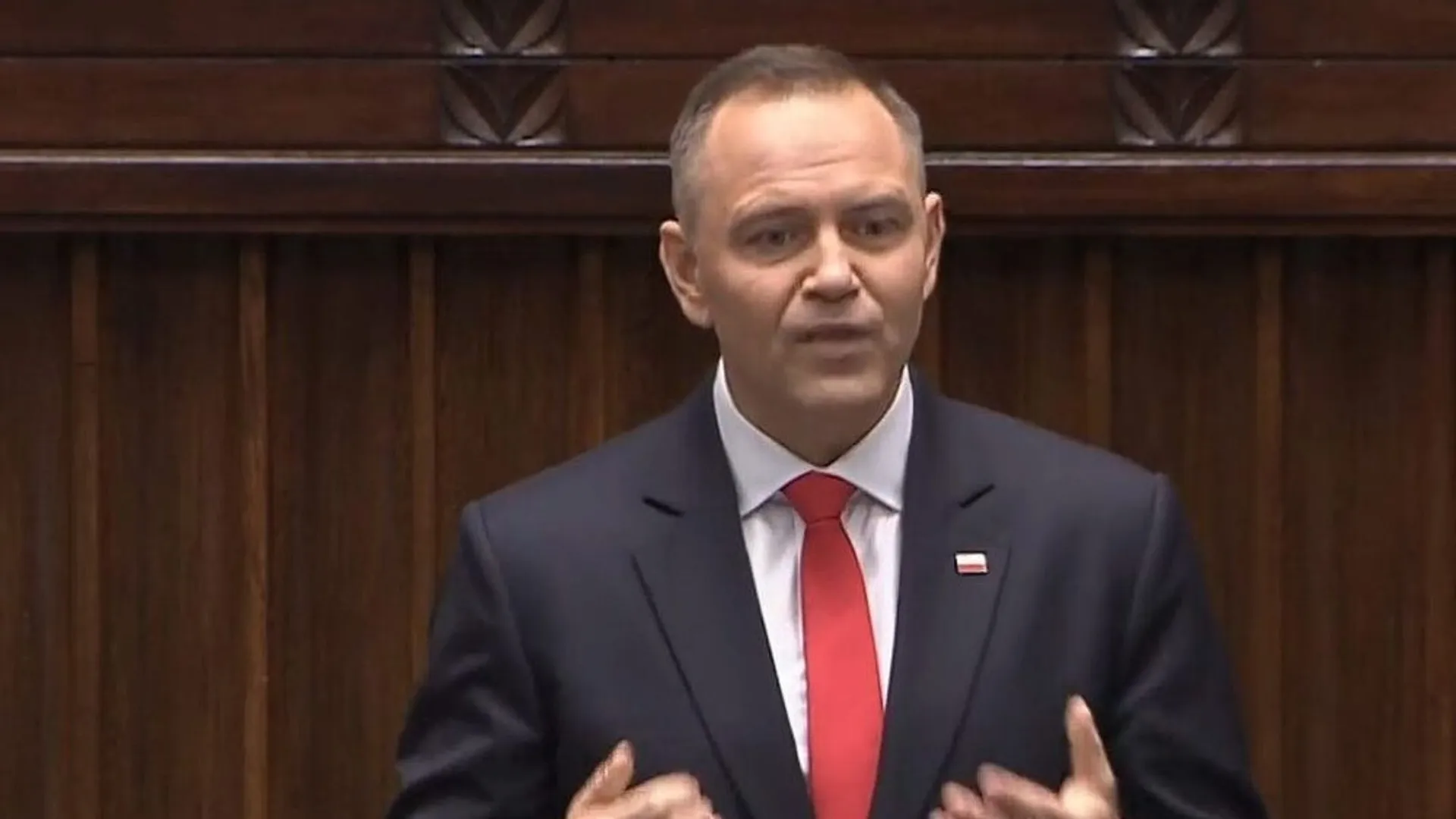

Rozwój sztucznej inteligencji, w tym technologii umożliwiających tworzenie deepfake’ów, rodzi poważne wyzwania dla systemu prawnego i instytucji państwowych – ocenił prezes Urzędu Ochrony Danych Osobowych Mirosław Wróblewski

Jednym z nich jest tzw. inferencja danych. Nowoczesne algorytmy potrafią wyciągać daleko idące wnioski na temat człowieka na podstawie pozornie niewinnych informacji. Styl pisania, aktywność w sieci, historia zakupów czy godziny logowania mogą wystarczyć, by system określił poglądy polityczne, stan zdrowia psychicznego, sytuację finansową czy problemy osobiste danej osoby. Co istotne – użytkownik często nie ma świadomości, że takie profile w ogóle powstają.

Technologia rozwija się szybciej niż praktyka stosowania prawa. Bez zmian w regulacjach i wzmocnienia ich egzekwowania ochrona danych osobowych i godności człowieka pozostanie jedynie deklaracją – podsumował Wróblewski.

Równie niepokojące jest ryzyko związane z trenowaniem modeli AI na ogromnych zbiorach danych pochodzących z Internetu. Jeśli proces ten nie jest odpowiednio zabezpieczony, istnieje możliwość, że algorytmy „zapamiętają” wrażliwe informacje. W skrajnych przypadkach dane te mogą zostać później wydobyte z modelu przy użyciu specjalistycznych technik. Oznacza to, że raz udostępniona informacja może krążyć w ekosystemie sztucznej inteligencji latami, poza jakąkolwiek kontrolą osoby, której dotyczy.

To przesuwa granicę zagrożeń daleko poza kwestie wizerunkowe. Stawką staje się prawo do prywatności, autonomii informacyjnej i realnej kontroli nad własnymi danymi w świecie zdominowanym przez algorytmy.

Co trzeba zmienić, by chronić obywateli

Eksperci nie mają wątpliwości: bez szybkich i zdecydowanych działań prawo będzie coraz bardziej odstawać od technologii. Pierwszym krokiem powinno być stworzenie jasnych, precyzyjnych regulacji odnoszących się wprost do nadużyć z wykorzystaniem sztucznej inteligencji. Przepisy muszą jednoznacznie definiować, czym jest nielegalna manipulacja cyfrowa i jakie konsekwencje grożą za jej stosowanie.

W wielu krajach takie rozwiązania już funkcjonują. Wprowadzono tam uproszczone procedury administracyjne pozwalające na szybkie usuwanie nielegalnych treści oraz jednoznaczne sankcje karne. Dzięki temu organy ścigania nie muszą zastanawiać się, czy dany czyn „pasuje” do starych kategorii przestępstw.

Drugim kluczowym obszarem jest odpowiedzialność platform internetowych. Serwisy społecznościowe i portale wideo od lat powołują się na status neutralnych pośredników, jednak w praktyce aktywnie kształtują zasięg treści poprzez algorytmy rekomendacyjne. Jeśli system promuje zmanipulowane materiały, fałszywe reklamy czy treści naruszające prawa innych osób, trudno mówić o neutralności.

Wzmocnienie obowiązków platform w zakresie monitorowania, reagowania i usuwania treści generowanych przez AI staje się koniecznością. Bez tego internetowe giganty będą nadal korzystać z technologicznego chaosu, jednocześnie unikając realnej odpowiedzialności.